فایل robots.txt چیست؟ فایل robots.txt چه استفاده ای دارد؟ زبان موتورهای جستوجو: چگونه فایل robots.txt بنویسم؟ فایل robots.txt کجا باید اضافه شود؟ robots.txt در افزونه…

آنچه در این مطلب خواهید خواند

پست های اخیر

هر کشوری زبان خاص خودشو داره و اگه بخوایم با افراد کشور خاصی ارتباط برقرار کنیم باید زبان همون کشور رو یاد بگیریم. خزنده های موتورهای جستجو هم زبان خودشون رو دارند و برای اینکه باهاشون صحبت کنیم و به اون ها بگیم کدوم صفحات از وب سایتمون رو بررسی کنند و از کدام صفحات دور بمانند باید از فایل robots.txt استفاده کنیم. در این مقاله زبان موتورهای جستجو و روش ساخت فایل robots.txt رو آموزش میدیم، پس تا انتها همراه ما باشید.

مقاله ریدایرکت ۳۰۱ چیست میتواند برای شما مفید باشد.

فهرست مطالب:

- فایل robots.txt چیست؟

- فایل robots.txt چه استفاده ای دارد؟

- زبان موتورهای جستوجو: چگونه فایل robots.txt بنویسم؟

- فایل robots.txt کجا باید اضافه شود؟

- robots.txt در افزونه رنک مث

- ساختار فایل robots.txt

- صفحه های جستجوی داخلی را مسدود کنید

- چگونه ارور ها یا خطاهای فایل robots.txt را برطرف کنیم؟

- جمع بندی

فایل robots.txt چیست؟

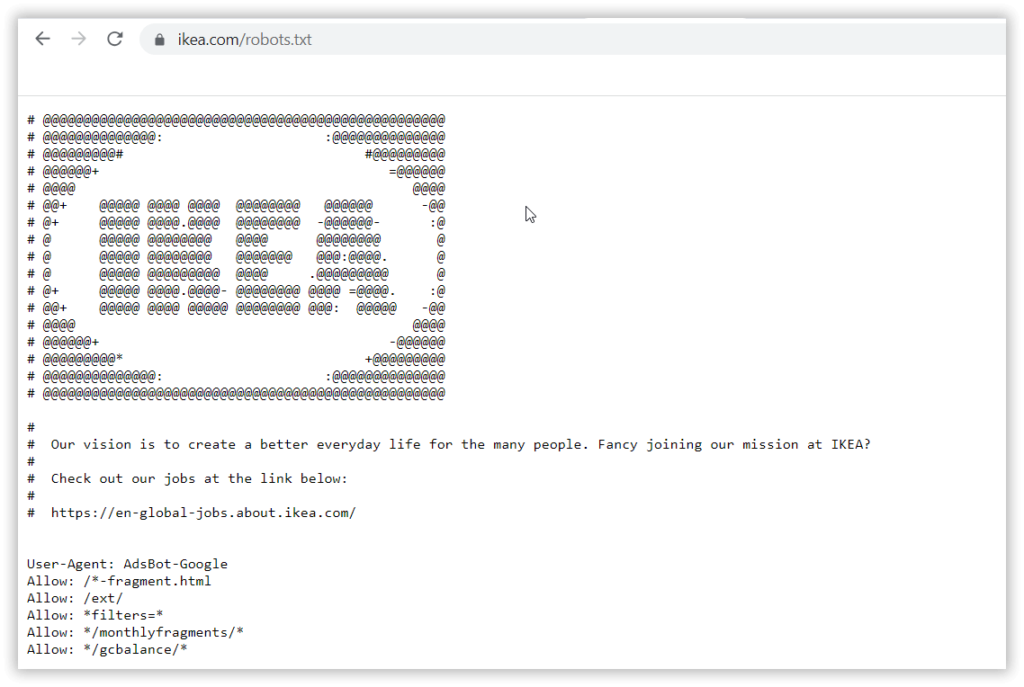

فایل robots.txt به خزنده های موتورهای جستجو مانند ربات گوگل میگه وقتی میان تو سایت ما چه قوانینی رو باید رعایت کنند. میتونید فایل robots.txt تمام وب سایت ها رو مشاهده کنید، تنها کافیه بعد از دامنه آن وب سایت “robots.txt/” رو اضافه کنید. برای مثال فایل robots.txt سایت ایمالز رو اینجا میتونید ببینید:

اساسی ترین استفاده این فایل:

منع کردن موتورهای جستجو از بخش های مختلف وب سایت شما هست.

در کل اگر قصد مسدود کردن هیچ کدوم از صفحات وب سایت خودتون رو ندارید، درست کردن فایل robots.txt براتون مثل آب خوردنه. اگر دوست دارید با موارد استفاده و روش ساخت فایل robots.txt آشنا بشید، در ادامه با ما همراه باشید.

فایل robots.txt چه استفاده ای دارد؟

هر وب سایتی باید یه فایل robots.txt داشته باشه، مخصوصا اگر میخواید وب سایت شما در گوگل رتبه بگیره. خود شرکت گوگل اعلام کرده که سایت ها باید این فایل را داشته باشند. اگر سایتتون فایل robots.txt نداشته باشه از لحاظ تئوری ربات های گوگل اون رو بررسی نخواهند کرد.

این فایل برای سایت های فروشگاهی بسیار کاربردی هستش. سایت های فروشگاهی به کابران اجازه میدن محصولات مورد نظر خود را جستوجو کنند و یا برای جستوجوی خود فیلتر تعیین کنند. هر فیلتری که تعیین میشه صفحهای رو می سازه که سبب ازدحام بیش از حد میشه. این صفحات باعث میشن ربات ها گیج بشن و ممکنه صفحات مهم وب سایت شما رو میون این همه شلوغی پیدا نکنند. برای اینکه بهتر با قضیه آشنا بشوید، بیاید فایل robots.txt سایت دیجی کالا رو با هم بررسی کنیم.

همونطور که میدونید، دیجی کالا در وب سایت خودش محصولات زیادی داره و برای اینکه این شلوغی رو کم کنه، در فایل robots.txt صفحاتی که با سرچ محصولات توسط کاربر ایجاد میشن رو مسدود کرده و اجازه خزیدن تو اون صفحات رو به ربات های گوگل نمیده، تا این ربات ها بتونند صفحات مهم تر رو بررسی کنند. در مورد این موضوع در قسمت صفحه های جستجوی داخلی را مسدود کنید بیشتر توضیح میدیم.

کاربرد دیگهای که این فایل ها دارند اینه که توی فایل robots.txt خودتون میتونید موتورهای جستوجو رو از خزیدن در فایلهای خاص مثلا عکسها، پی دی افها و یا شیت های اکسلی که توی وب سایتتون هست منع کنید. به عنوان مثال، شما اطلاعات شخصی کاربران رو ذخیره کردید و مسلما نمیخواین که این فایل ها در جستجوی گوگل نشون داده بشن، بنابراین به ربات های گوگل اجازه دسترسی و خزیدن در این فایل ها رو نمیدید.

کاربرد سوم فایل robots.txt اینه که میتونید بخش هایی از وب سایتتون رو به صورت خصوصی یا همون private دربیارید. برای اینکار باید اجازه دسترسی به مسیر فایل و یا پارامترهای URL رو از خزندههای موتورهای جستوجو بگیرید.

کاربرد چهارم فایل robots.txt اینه که میتونید در خزش تاخیر ایجاد کنید؛ تا زمانی که خزندهها محتواهای مختلف سایت شما رو لود می کنند، سرورتون دچار اورلود (Overload) نشه.

در نهایت هم میتونین لوکیشن سایت مپ و یا همون نقشه سایتتون رو توی فایل robots.txt بذارید تا خزنده ها راحت پیداش کنند.

اگه روش ساخت سایت مپ رو بلد نیستین، به مقاله روش ساخت نقشه سایت در وردپرس ما سر بزنید.

حالا که میدونیم با فایل robots.txt چه کارهایی میشه کرد، بیاید با زبان خزنده های موتور جستجو آشنا بشیم تا بتونید خودتون فایل robots.txt برای سایتتون درست کنید.

زبان موتورهای جستوجو: چگونه فایل robots.txt بنویسم؟

به زبان موتورهای جستجو اصطلاحا robots.txt synatx گفته میشه. اولین چیزی که تو این زبان باید باهاش آشنا بشید User-agent هست.

User-agent: این سینتکس برای صدا زدن موتورهای جستجویی هستش که میخواید وب سایت شما رو بررسی بکنند و یا همون به اصطلاح تو وب سایتتون بخزند. وقتی خزندهای وارد سایت شما میشه اول کاری که میکنه اینه که فایل robot.txt شما رو میخونه؛ یعنی این فایل رو اسکن میکنه تا ببینه صداش زدید یا نه. اگر صداش زده بودید به خوندن اون قسمت هایی که بهش مربوط هستند ادامه میده. لیست تمامی User-agent ها یا همون خزنده های موتور جستجو رو میتونید اینجا ببینید.

Disallow: سینکس بعدی که میخوایم بررسی کنیم Disallow Rule هست. این سینتکس همونطور که از اسمش پیداست به خزنده ها میگه که وارد بخشهای خاصی از وب سایت شما نشن؛ یعنی اجازه دسترسی به اون قسمتهای سایتتون رو ازشون میگیرید. یادتون باشه تو هر لاین فقط یدونه دستور Disallow میتونید اضافه کنید. میبینید که سایت دیجی چقدر این دستور رو توی فایل robots.txt خودش اضافه کرده:

Allow: این سینتکس فقط برای یکی از خزنده گوگل به اسم Googlebot کاربرد داره که بهش اجازه میده به یه برگه یا زیرپوشه (Subfolder) دسترسی داشته باشه با اینکه برگه مادر یا فایل مادر Disallow شده.

تو مثال زیر، اجازه دسترسی از فولدر مادر /wp-admin/ گرفته شده اما به /wp-admin/admin-ajax.php که فایلی داخل فایل مادر هستش اجازه دسترسی داده شده:

User-agent: Googlebot

/Disallow: /wp-admin

Allow: /wp-admin/admin-ajax.phpCrawl-Delay: سینتکس Crawl-Delay به خزنده میگه که قبل از شروع به لود کردن و خزیدن سایت شما چند ثانیه منتظر بمونه. سینتکس Crawl-Delay این شکلیه:

* :User-agent

Crawl-Delay: 20نقشه سایت: در نهایت هم لوکیشن سایت مپ XML رو توی فایل robots.txt تون برای خزنده ها میذارید.

Sitemap: https://parsavesta.com/sitemap_index.xml/: علامت اسلش رو هم داریم که جدا کننده هست. اگر به تنهایی مانند مثال زیر ازش استفاده کنید، به این معنیه که کل سایت شما disallow شده:

User-agent: Googlebot

/ :Disallow*: علامت بعدی علامت ستاره هست. زمانی از این علامت استفاده میکنید که بخواید دستوری رو توی تمام اجزای یه بخش اعمال کنید؛ یعنی وقتی علامت ستاره رو گذاشتین بعدش بخش خاصی رو مشخص کردین، هر چیزی که مربوط به اونه باید در نظر گرفته بشه. به عنوان مثال، همونطور که در عکس میبینید توی فایل robots.txt دیجی کالا *؟* Disallow شده؛ یعنی به خزنده ها گفته هر چی بعد از پارامتر علامت سوال توی URL اومد رو لازم نیست بررسی کنی.

اگر به تنهایی علامت ستاره رو بذارید تمام اون چیز مدنظرتونه، مثلا توی عکس بالا * :user-agent یعنی تمام خزنده های موتور جستجو رو صدا کردید و بهشون اجازه بررسی سایت خودتون رو دادید.

#: هر چیزی که بعد از هشتگ توی فایل robots.txt شما قرار بگیره، به عنوان comment در نظر گرفته میشه؛ یعنی ما از ربات های موتور جستجو میخوایم که اون ها را نادیده بگیره. به عنوان مثال، میتونین موارد استفاده هشتگ رو توی فایل robots.txt سایت رنک مث ببینید:

This file is automatically added by Rank Math SEO plugin to help a website index better #

/More info: https://rankmath.com/wordpress/plugin/seo-suite #

* :User-Agent

/Disallow: /wp-admin

Allow: /wp-admin/admin-ajax.php

Allow: /wp-json/rankmath/v1/updateCheck

Sitemap: https://rankmath.com/sitemap_index.xmlیا مثلا ببینید که سایت ikea با استفاده از هشتگ چجوری ابتکار به خرج داده و توی فایل robots.txt هم کسب و کار خودش رو تبلیغ کرده:

$: در نهایت هم علامت دلار، نشون دهنده انتهای مسیر URL هستش. توی مثال زیر پارامتر solutions و هر اسلاگ یو آر الی که بعد از اون میاد Disallow شده:

$/Disallow: /solutionsفایل robots.txt کجا باید اضافه شود؟

فایل robots.txt باید به دایرکتوری وب سایت اضافه بشه. همونطور که گفتم، وقتی خزنده های موتور جستجو سایت شما را پیدا می کنن، اول از همه دنبال فایل robots.txt وب سایتتون میگردن. فایل robots.txt توی فایل منیجر وب ساتتون هست و تو قسمت home>public_html باید اضافه اش کنید.

robots.txt در افزونه رنک مث

اگر از رنک مث استفاده می کنید دیگه نیازی نیست فایل robots.txt رو در فایل منیجر وب سایتتون اضافه کنید، چون این افزونه یه بخش جدا برای این فایل داره.

برای مدیریت فایل robots.txt در افزونه رنک مث به قسمت General settings و یا همان تنظیمات عمومی بروید. روی قسمت Edit robots.txt کلیک کنید و فایلی که افزونه رنک مث به طور پیش فرض برای سایتتون درست کرده رو میتونید مشاهده کنید:

* :User-agent

/Disallow: /wp-admin

Allow: /wp-admin/admin-ajax.php

Sitemap: https://parsavesta.com/sitemap_index.xmlتوی این فایل robots.txt خزنده های تمام موتورهای جستجو به سایت دعوت شده و ازشون خواسته شده که فایل /wp-admin/ که همون قسمت مدیریت وردپرس هستش رو ایندکس نکنن، اما اگه بخوان فقط وارد /Allow: wp-admin/admin-ajax.php بشن هیچ مشکلی نداره و در نهایت هم آدرس سایت مپ رو براشون به اشتراک گذاشته. اگر محدودیتی برای موتورهای جستجو در سایتتون وجود نداره، همین فایل پیش فرض براتون کفایت می کند. اما اگر نیاز به اعمال محدودیت در سایتتون دارید این مقاله رو تا آخر بخونید.

ساختار فایل robots.txt

فایل robots.txt میتونه از گروه های مختلفی تشکیل شده باشه و هر گروه میتونه قانون ها و یا دستورهای مختلفی رو درون خودش بگنجونه. اما یادتون باشه که:

- هر گروه رو حتما باید با سینتکس User-agent شروع کنید

- در ادامه قانون هایی که خزنده ها باید رعایت کنند رو بیان کنید

- هر قانون باید در لاین جداگانه نوشته بشه

- نباید یک دایرکتوری رو در لاین های جدا بنوسید

به صورت پیشفرض خزنده های موتورهای جستجو میتونند تمام صفحات سایت شما رو بخزنند، مگر اینکه با استفاده از سینتکس Disallow محدویت هایی براشون قائل بشید. اگر بخواید خزنده های بیشتری رو مورد خطاب قرار بدید، از این ساختار باید استفاده کنید:

* :User-agent

/Disallow: /wp-admin

Allow: /wp-admin/admin-ajax.php

User-agent: msnbot

/ :Disallow

Sitemap: https://parsavesta.com/sitemap_index.xmlاین ساختار فایل robots.txt هستش. حالا که میتونیم با خزنده های موتور جستجو با زبان خودشون صحبت کنیم، بریم یه مثال ببینیم.

صفحه های جستجوی داخلی را مسدود کنید

بسته به نوع وب سایتی که دارید، بهتره صفحات جستجوی داخلی رو برای خزنده های موتور جستجو مسدود کنید. مثلا وقتی وارد سایت دیجی کالا میشید، میبینید که گزینه جستجوی داخلی داره. اگر موبایل رو جستجو کنید، URL به شکل زیر در میاد:

موبایل=www.digikala.com/search/?qحالا اگه کیف رو توی دیجیکالا سرچ کنیم، URL به این شکل در میاد:

کیف=https://www.digikala.com/search/?qمیتونید الگو رو پیدا کنید؟

هر بار که توی دیجی کالا جستجوی داخلی انجام میدیم *=search?q رو توی URL میبینیم. حالا دیجی کالا اینجوری توی فایل robots.txt این صفحات رو برای خزنده ها مسدود کرده:

چگونه ارور ها یا خطاهای فایل robots.txt را برطرف کنیم؟

بهترین راه برای اینکه مطمئن بشید فایل robots.txt شما خطا یا ارور نداره، robots.txt Tester گوگل هستش. اگه سرچ کنسول داشته باشید، توی robots.txt Tester میتونین فایل robots.txt خودتون رو ببینید.

اگر دیدید که فایل robots.txt شما با چیزی که براتون توی robots.txt Tester نمایش داده میشه متفاوته، robots.txt خودتون رو کپی کنید و در robots.txt Tester بذارید، حالا گزینه submit رو بزنید. این پیام براتون میاد که گزینه سوم رو باید انتخاب کنید:

حالا صفحه رو ریفرش کنید. اگر فایل robots.txt شما خطا داشته باشه، یه علامت براتون کنار همون لاین میاد مثل تصویر زیر:

جمع بندی

امیدوارم در این مقاله روش ساخت فایل robots.txt رو یاد گرفته باشید. فایل های txt ممکنه در ابتدا پیچیده به نظر بیان، اما اگه خوب اون ها درک کنید، متوجه میشید که بسیار ساده هستند، تنها کافیه زبان موتور جستجو رو یاد بگیرید. ممنون که تا اینجا همراه ما بودید، هر نظری و یا سوال در مورد فایل های robots.txt داشتید باهامون به اشتراک بذارید.

0

0

رای ها

امتیازدهی به مقاله

اشتراک در

وارد شدن

0 نظرات

قدیمیترین

تازهترین

بیشترین رأی

بازخورد (Feedback) های اینلاین

مشاهده همه دیدگاه ها